Как закрыть сайт от индексации поисковых систем: 4 проверенных способа. Сайт закрыть

Как закрыть сайт от индексации за 1 минуту: 3 способа

Привет всем, друзья!Иногда возникают ситуации, когда необходимо закрыть сайт от индексации. Ну, например вы решили сменить дизайн блога и не хотите, чтобы в это время на ресурс заходили поисковые боты. Или просто вы только что создали сайт и установили на него движок, соответственно если на ресурсе нет полезной информации, то показывать его поисковым ботам не стоит. В данной статье вы узнаете о том, как закрыть сайт от индексации в Яндексе, Гугле, или сразу во всех поисковых системах. Но перед тем вы также можете прочитать еще одну похожую статью: «Как закрыть ссылку от индексации?» А теперь приступим.

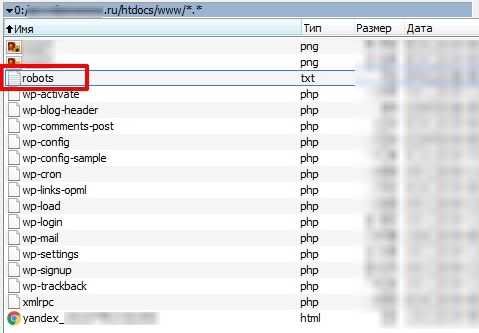

1. Закрываем сайт от индексации с помощью файла robots.txt.Для начала вам нужно создать файл robots.txt. Для этого создаете на своем компьютере обычный текстовый документ с названием robots и расширением .txt. Вот я только что создал его:

Теперь этот файл нужно загрузить в корневую папку своего блога. Если ресурс сделан на движке вордпрес, то корневая папка находится там, где папки wp-content, wp-includes и т. д.

Итак, мы загрузили пустой файл на хостинг, теперь нужно с помощью этого файла как-то закрыть блог от индексации. Это можно сделать, как я уже написал только для Яндекса, Гугла или сразу всех поисковиков. Давайте обо всем по порядку.

Как закрыть сайт от индексации только для Яндекса?Пропишите в файле robots.txt вот такую строчку:

User-agent: Yandex Disallow: /Для того чтобы убедиться в том, что вы запретили индексировать свой ресурс Яндексу, добавьте сначала сайт в Яндекс Вебмастер, если вы этого еще не сделали, а потом перейдите на эту страницу. Дальше введите несколько страниц своего сайта и нажмите на кнопку «Проверить». Если страницы запрещены к индексации, то вы увидите примерно такую картину:

Как закрыть сайт от индексации только для Google?Откройте файл robots.txt и пропишите там вот такую строчку:

User-agent: Googlebot Disallow: /Для того чтобы проверить, что Гугл не индексирует сайт, создайте аккаунт, добавьте свой ресурс в Google Webmaster и перейдите вот сюда. Здесь также нужно ввести несколько страниц и нажать на кнопку «проверить».

Если страница разрешена к индексированию, то будет писать «Разрешено», в таком случае вы сделали что-то не так. Если документ запрещен к индексации, то будет писать «Заблокировано по строке», и Гугл укажет строку, с помощью которой страница запрещена к индексации. Вы также можете прочитать статью о том, как проверить индексацию сайта.

Я заметил, что поисковая система Google индексирует даже те документы, которые запрещены в файле robots.txt и заносит их в дополнительный индекс, так называемые «сопли». Почему, не знаю, но вы должны понимать, что запретить сайт или отдельную страницу с помощью файла robots.txt на 100 % нельзя. Этот файл, как я понял, только рекомендация для Гугла, а он уже сам решает, что ему индексировать, а что нет.

Как закрыть сайт от индексации для всех поисковых систем?Чтобы запретить сразу всем поисковикам индексировать ваш ресурс, пропишите в robots.txt вот такую строчку:

User-agent: * Disallow: /Теперь вы также можете перейти в Яндекс или Гугл Вебмастер и проверить запрет индексации.

Свой файл robots.txt вы можете увидеть по такому адресу:

Все что вы прописали в этом файле должно отображаться в браузере. Если при переходе по этому адресу перед вами выскакивает ошибка 404, значит, вы не туда загрузили свой файл.

Кстати, мой robots.txt находиться здесь. Если ваш ресурс сделан на движке wordpress, то можете просто скопировать его. Он правильно настроен для того, чтобы поисковые боты индексировали только нужные документы и что бы на сайте не было дублей.

2. Закрываем сайт от индексации с помощью панели инструментов.Этот способ подойдет только для тех, чей ресурс сделан на вордпрес. Зайдите в «Панель управление» — «Настройки» — «Чтение». Здесь нужно поставить галочку напротив надписи «Рекомендовать поисковым машинам не индексировать сайт».

Обратите внимание, что ниже находиться очень интересная надпись: «Поисковые машины сами решают, следовать ли Вашей просьбе». Это как раз то, о чем я писал выше. Яндекс скорее всего не будет индексировать страницы, которые запрещены к индексации, а вот с Гуглом могут возникнуть проблемы.

3. Закрываем сайт от индексации вручную.Когда вы закрываете целый ресурс или страницу от индексации, то в исходном коде автоматически появляется вот такая строчка:

Она и говорит поисковым ботам, что документ индексировать нельзя. Вы можете просто вручную прописать эту строчку в любом месте своего сайта, главное чтобы она отображалась на всех страницах и тогда ресурс будет закрыт от индексации.

Кстати, если вы создаете ненужный документ на своем сайте, и не хотите чтобы поисковые боты его индексировали, то можете также вставить в исходном коде эту строчку.

После обновления откройте исходный код страницы (CTRL + U) и посмотрите, появилась ли эта строчка там. Если есть, значит все хорошо. На всякий случай можете еще проверить с помощью инструментов для вебмастеров от Яндекса и Гугла.

На этом все на сегодня. Теперь вы знаете, как закрыть сайт от индексации. Надеюсь, эта статья была полезна для вас. Всем пока.

vachevskiy.ru

Как закрыть сайт от индексации?

Приветствую вас, посетители сайта Impuls-Web!

Когда вы только приступили к созданию сайта и не хотите, что бы поисковые системы индексировали его до завершения работ, вы может закрыть сайт от индексации в поисковых системах.

Навигация по статье:

Так же такая необходимость может возникнуть для тестового сайта, или для сайта, который предназначен для закрытого пользования определенной группой лиц, и вам не нужно, чтобы внутренние ссылки попали в выдачу поисковиков.

Я хочу вам сегодня показать несколько достаточно простых способов, как можно закрыть сайт от индексации.

Как закрыть сайт от индексации в WordPress?

Данный способ, наверное, самый простой, и владельцам сайтов, которые созданы на базе CMS WordPress, очень повезло. Дело в том, что в данной CMS предусмотрена возможность закрытия сайта от индексации при установке движка на хостинг. В случае если вы не сделали этого при установке, вы всегда можете это сделать в настройках. Для этого вам нужно:

- 1.В админпанели переходим в раздел «Настройки» → «Чтение».

- 2.Перелистываем открывшуюся страницу в самый низ, и отмечаем галочкой опцию показанную на скриншоте:

- 3.Сохраняем изменения.

Все. Теперь ваш сайт не будет индексироваться. Если открыть страницу в браузере и нажать комбинацию клавиш CTRL+U, мы сможем просмотреть код страницы, и увидим вот такую строку кода:

Данная запись была добавлена автоматически, после того как мы включили опцию запрета индексации в настройках.

Главное не забыть отключить эту опцию после завершения работ:)

Как закрыть сайт от индексации name=»robots»?

Данный способ заключается в самостоятельном добавлении записи, показанной на предыдущем скриншоте. Данный вариант подойдет для тех сайтов, которые создаются без использования CMS.

Вам всего лишь нужно в начале каждой страницы, перед закрытием тега </head> добавить эту запись:

<meta name='robots' content='noindex,follow' />

<meta name='robots' content='noindex,follow' /> |

В поле content можно задать следующие условия:

Запрещающие условия:

- none – запрет для страниц и ссылок;

- noindex – запрет для страниц;

- nofollow – запрещает индексацию ссылок на странице;

Разрещающие условия:

- all – разрешает индексацию страниц и ссылок;

- index — разрешает индексацию страниц;

- follow – разрешает индексацию ссылок на странице;

Зная данный набор условий, мы можем составить альтернативную запись для полного запрета для сайта и ссылок на нем. Выглядеть она будет вот так:

<meta name='robots' content='none' />

<meta name='robots' content='none' /> |

Как закрыть сайт от индексации в robots.txt?

Показанные выше варианты закрытия сайта от индексации работают для всех поисковиков, а это бывает не всегда нужно. Так же, предыдущий способ достаточно неудобен в случае, если ваш ресурс состоит из большого количества страниц, и каждую из них нужно закрыть от индексации.

В этом случае лучше воспользоваться еще одним способом закрытия сайта от индексации. Данный вариант дает нам возможность более гибко закрывать от индексации не только сайт в целом, но и отдельные страницы, медиафайлы и папки.

Для полного закрытия от индексации вам нужно создать в редакторе кода NotePad++ файл с названием robots.txt и разместить в нем такую запись:

User-agent: * Disallow: /

User-agent со значением * означает, что данное правило предназначено для всех поисковых роботов. Так же вы можете запретить индексацию для какой-то поисковой системы в отдельности. Для этого в User-agent указываем имя конкретного поискового робота. Например:

В этом случае запись будет работать только для Яндекса.

Обратите внимание. В строке User-agent может быть указан только один поисковый робот, и соответственно директивы Disallow, указанные ниже будут работать только для него. Если вам нужно запретить от индексацию в нескольких ПС, то вам нужно это сделать по отдельность для каждой. Например:User-agent: Googlebot Disallow: / User-agent: Yandex Disallow: /

User-agent: Googlebot Disallow: /

User-agent: Yandex Disallow: / |

Так же, директива Disallow позволяет закрывать отдельные элементы. Данная директива указывается отдельно для каждого закрываемого элемента. Например:

User-agent: Yandex Disallow: *.jpg Disallow: /about-us.php

User-agent: Yandex Disallow: *.jpg Disallow: /about-us.php |

Здесь для поискового робота Yandex закрыты для индексации все изображение с расширением .jpg и страница /about-us.php.

Каждый из показанных приемов удобен по своему в зависимости от сложившейся ситуации. Надеюсь у меня получилось достаточно подробно рассказать вам о способах закрытия сайта от индексации, и данный вопрос у вас не вызовет трудностей в будущем.

Если данная информация была для вас полезно, обязательно оставьте свой комментарий под статьей и поделитесь ею в социальных сетях.

Желаю вам успехов в создании сайтов. До встречи в следующих статьях!

С уважением Юлия Гусарь

impuls-web.ru

4 способа закрыть сайт от индексации в Google и Яндекс

Очень часто требуется закрыть сайт от индексации, например при его разработке, чтобы ненужная информация не попала в индекс поисковых систем или по другим причинам. При этом есть множество способов, как это можно сделать, все их мы и рассмотрим в этой статье.

Зачем сайт закрывают для индекса?

Есть несколько причин, которые заставляют вебмастеров скрывать свои проекты от поисковых роботов. Зачастую к такой процедуре они прибегают в двух случаях:

-

- Когда только создали блог и меняют на нем интерфейс, навигацию и прочие параметры, наполняют его различными материалами. Разумеется, веб-ресурс и контент, содержащийся на нем, будет не таким, каким бы вы хотели его видеть в конечном итоге. Естественно, пока сайт не доработан, разумно будет закрыть его от индексации Яндекса и Google, чтобы эти мусорные страницы не попадали в индекс.

Не думайте, что если ваш ресурс только появился на свет и вы не отправили поисковикам ссылки для его индексации, то они его не заметят. Роботы помимо ссылок учитывают еще и ваши посещения через браузер.

- Иногда разработчикам требуется поставить вторую версию сайта, аналог основной на которой они тестируют доработки, эту версию с дубликатом сайта лучше тоже закрывать от индексации, чтобы она не смогла навредить основному проекту и не ввести поисковые системы в заблуждение.

- Когда только создали блог и меняют на нем интерфейс, навигацию и прочие параметры, наполняют его различными материалами. Разумеется, веб-ресурс и контент, содержащийся на нем, будет не таким, каким бы вы хотели его видеть в конечном итоге. Естественно, пока сайт не доработан, разумно будет закрыть его от индексации Яндекса и Google, чтобы эти мусорные страницы не попадали в индекс.

Какие есть способы запрета индексации сайта?

- Панель инструментов в WordPress.

- Изменения в файле robots.txt.

- Посредством мета-тега name=“robots”

- Написание кода в настройках сервера.

1. Закрытие индексации через WordPress

Если сайт создан на базе WordPress, это ваш вариант. Скрыть проект от ботов таким образом проще и быстрее всего:

- Перейдите в «Панель управления».

- Затем в «Настройки».

- А после – в «Чтение».

- Отыщите меню «Видимость для поисковиков».

- Возле строки «Рекомендовать поисковым роботам не индексировать сайт» поставьте галочку.

- Сохраните изменения.

Благодаря встроенной функции, движок автоматически изменит robots.txt, откорректировав правила и отключив тем самым индексацию ресурса.

На заметку. Следует отметить, что окончательное решение, включать сайт в индекс или нет, остается за поисковиками, и ниже можно увидеть это предупреждение. Как показывает практика, с Яндексом проблем не возникает, а вот Google может продолжить индексировать документы.

2. Посредством файла robots.txt

Если у вас нет возможности проделать эту операцию в WordPress или у вас стоит другой движок сайта, удалить веб-сайт из поисковиков можно вручную. Это также реализуется несложно. Создайте обычный текстовый документ, разумеется, в формате txt, и назовите его robots.

Затем скиньте его в корневую папку своего портала, чтобы этот файл мог открываться по такому пути site.ru/robots.txt

Но сейчас он у вас пустой, поэтому в нем потребуется прописать соответствующие команды, которые позволят закрыть сайт от индексации полностью или только определенные его элементы. Рассмотрим все варианты, которые вам могут пригодиться.

Закрыть сайта полностью для всех поисковых систем

Укажите в robots.txt команду:

User-agent: * Disallow: /Это позволит запретить ботам всех поисковиков обрабатывать и вносить в базу данных всю информацию, находящуюся на вашем веб-ресурсе. Проверить документ robots.txt, как мы уже говорили, можно, введя в адресной строке браузера: Название__вашего_домена.ru/robots.txt. Если вы все сделали правильно, то увидите все, что указано в файле. Но если, перейдя по указанному адресу, вам выдаст ошибку 404, то, скорее всего, вы скинули файл не туда.

Отдельную папку

User-agent: * Disallow: /folder/Так вы скроете все файлы, находящиеся в указанной папке.

Только в Яндексе

User-agent: Yandex Disallow: /Чтобы перепроверить, получилось ли у вас удалить свой блог из Яндекса, добавьте его в Яндекс.Вебмастер, после чего зайдите в соответствующий раздел по ссылке https://webmaster.yandex.ru/tools/robotstxt/. В поле для проверки URL вставьте несколько ссылок на документы ресурса, и нажмите «Проверить». Если они скрыты от ботов, напротив них в результатах будет написано «Запрещено правилом /*?*».

Только для Google

User-agent: Googlebot Disallow: /Проверить, получилось ли сделать запрет, или нет, можно аналогичным способом, что и для Яндекса, только вам нужно будет посетить панель вебмастера Google Search Console. Если документ закрыт от поисковика, то напротив ссылки будет написано «Заблокировано по строке», и вы увидите ту самую строку, которая дала команду ботам не индексировать его.

Но с большой вероятностью вы можете увидеть «Разрешено». Здесь два варианта: либо вы что-то сделали неправильно, либо Google продолжает индексировать запрещенные в документе robots страницы. Я уже упоминал об этом выше, что для поисковых машин данный документ несет лишь рекомендационный характер, и окончательное решение по индексированию остается за ними.

Для других поисковиков

Все поисковики имеют собственных ботов с уникальными именами, чтобы вебмастера могли прописывать их в robots.txt и задавать для них команды. Представляем вашему вниманию самые распространенные (кроме Яндекса и Google):

- Поисковик Yahoo. Имя робота – Slurp.

- Спутник. Имя робота – SputnikBot.

- Bing. Имя робота – MSNBot.

Список имен всех ботов вы с легкостью найдете в интернете.

Скрыть изображения

Чтобы поисковики не могли индексировать картинки, пропишите такие команды (будут зависеть от формата изображения):

User-Agent: * Disallow: *.png Disallow: *.jpg Disallow: *.gifЗакрыть поддомен

Любой поддомен содержит собственный robots.txt. Как правило, он находится в корневой для поддомена папке. Откройте документ, и непосредственно там укажите:

User-agent: * Disallow: /Если такого текстового документа в папке поддомена нет, создайте его самостоятельно.

3. С применением тега name=”robots”

Еще один способ, который поможет скрыть от роботов поисковых систем какой-либо документ или полностью весь сайт – использование мета-тега robots. Данный вариант является одним из самых приоритетных к исполнению для поисковиков. Для этого в любом месте, но обязательно внутри тегов <head> и </head>, нужно прописать код:

<meta name=”robots” content=”noindex, nofollow”/>или

<meta name=”robots” content=”none”/>4. В настройках сервера

И последний способ, о котором хочу вам рассказать – обращение к серверу. К этому варианту вебмастера прибегают в тому случае, когда роботы вообще никак не реагируют на действия, описанные выше. Такое иногда случается, и тогда приходится решать проблему в настройках сервера посредством файла .htacces. Откройте его и пропишите в нем это:

SetEnvIfNoCase User-Agent "^Googlebot" search_bot SetEnvIfNoCase User-Agent "^Yandex" search_bot SetEnvIfNoCase User-Agent "^Yahoo" search_bot SetEnvIfNoCase User-Agent "^Aport" search_bot SetEnvIfNoCase User-Agent "^msnbot" search_bot SetEnvIfNoCase User-Agent "^spider" search_bot SetEnvIfNoCase User-Agent "^Robot" search_bot SetEnvIfNoCase User-Agent "^php" search_bot SetEnvIfNoCase User-Agent "^Mail" search_bot SetEnvIfNoCase User-Agent "^bot" search_bot SetEnvIfNoCase User-Agent "^igdeSpyder" search_bot SetEnvIfNoCase User-Agent "^Snapbot" search_bot SetEnvIfNoCase User-Agent "^WordPress" search_bot SetEnvIfNoCase User-Agent "^BlogPulseLive" search_bot SetEnvIfNoCase User-Agent "^Parser" search_botЗаключение

Вне зависимости от того, по какой причине вы хотите закрыть сайт, отдельные его страницы или материалы от индексации, можете воспользоваться любым из перечисленных способов. Они простые в реализации, и на их настройку не потребуется много времени. Вы самостоятельно сможете скрыть нужную информацию от роботов, однако стоит учесть, что не все методы помогут на 100%.

webmasterie.ru

Как закрыть сайт на реконструкцию

Вы здесь: Главная - PHP - PHP Основы - Как закрыть сайт на реконструкцию

Когда Вы закрываете сайт на реконструкцию на определённый срок, то нужно сделать 2 шага: уведомить об этом всех приходящих пользователей, а также оставить доступ к сайту у Вас. Вот об выполнении этих 2-х шагов в этой небольшой статье мы и поговорим.

Первое дело, которое Вам нужно сделать - это создать страницу, куда будут перенаправляться все посетители. Допустим, пусть она называется "close.html". На этой странице напишите, что Ваш сайт закрыт на реконструкцию, можете добавить какую-нибудь картинку, если пожелаете. Далее эту страницу загрузите в корень сайта.

После создания и загрузки страницы для посетителей необходимо открыть доступ ко всему сайту для Вас. Для этого потребуется Ваш IP-адрес. Если Вы его не знаете, то зайдите сюда: http://2ip.ru. На этом сервисе Вы сразу увидите свой IP-адрес. Допустим, это будет: "95.243.188.124".

И, наконец, последний шаг - это добавление в файл .htaccess, находящийся в корне сайта, следующих строк:

RewriteEngine On RewriteCond %{REMOTE_ADDR} !95.243.188.124 RewriteRule ^(.*)$ close.html [L,QSA]Если перевести данный код, то он означает, что всех посетителей, чем IP-адрес отличен от "95.243.188.124", перенаправлять на страницу "close.html". Теперь ещё один важный момент. Вполне вероятно, что Вы добавляли картинку на страницу "close.html". Если это так, то Вам необходимо немного изменить код:

RewriteEngine On RewriteCond %{REMOTE_ADDR} !95.243.188.124 RewriteCond %{REQUEST_FILENAME} !image.jpg RewriteRule ^(.*)$ close.html [L,QSA]Как видите, добавлена всего одна строчка. Если у Вас используются ещё картинки, то добавляйте и их.

Давайте подведём небольшой итог о том, как закрыть сайт на реконструкцию:

- Создать страницу для посетителя о закрытии сайта на реконструкцию.

- Загрузить эту страницу в корень сайта.

- Узнать свой IP-адрес.

- Создать файл .htaccess с необходимым кодом, либо добавить этот код, если .htaccess уже создан.

Вот и всё, теперь Вы будете заходить на сайт так, как будто никакой реконструкции нет, а вот все посетители будут видеть страницу о том, что сайт на ремонте.

- Создано 26.09.2011 12:49:58

- Михаил Русаков

Копирование материалов разрешается только с указанием автора (Михаил Русаков) и индексируемой прямой ссылкой на сайт (http://myrusakov.ru)!

Добавляйтесь ко мне в друзья ВКонтакте: http://vk.com/myrusakov.Если Вы хотите дать оценку мне и моей работе, то напишите её в моей группе: http://vk.com/rusakovmy.

Если Вы не хотите пропустить новые материалы на сайте,то Вы можете подписаться на обновления: Подписаться на обновления

Если у Вас остались какие-либо вопросы, либо у Вас есть желание высказаться по поводу этой статьи, то Вы можете оставить свой комментарий внизу страницы.

Порекомендуйте эту статью друзьям:

Если Вам понравился сайт, то разместите ссылку на него (у себя на сайте, на форуме, в контакте):

-

Кнопка:

<a href="https://myrusakov.ru" target="_blank"><img src="https://myrusakov.ru//images/button.gif" alt="Как создать свой сайт" /></a>

Она выглядит вот так:

-

Текстовая ссылка:<a href="https://myrusakov.ru" target="_blank">Как создать свой сайт</a>

Она выглядит вот так: Как создать свой сайт

- BB-код ссылки для форумов (например, можете поставить её в подписи): [URL="https://myrusakov.ru"]Как создать свой сайт[/URL]

myrusakov.ru

Как закрыть сайт от индексации в Яндексе и Google

Мэт Катс, будучи в свое время официальным представителем Гугл для вебмастеров, в одном из своих видео, рассказал, как закрыть сайт от индексации, способ предельно простой – нужно просто не ставить ссылки на свой сайт. Про этот, а также про другие способы закрытия сайта от индексации, читайте дальше.

Хотя, на самом деле, не ставить ссылки на свой сайт, это тоже вариант, но и сам Мэт Катс, в своем видео признает – такой способ действительно возможен — теоретически, но фактически, это не вариант. Любой посетитель, зайдя на ваш сайт, может затем оставить эту ссылку где угодно. И все, как только поисковик пройдет по ссылке, ваш сайт окажется проиндексирован поисковиком.

Но на самом деле, есть и другие способы закрытия своего сайта. Одни из них, менее эффективные, другие дают сто процентную гарантию запрета. Давайте пройдемся по этим способам.

Я предполагаю, что вы уже знаете, что такое индексация сайта и почему она важна. Окей, пару слов об этом. Поисковики, что Яндекс, что Гугл, да и другие тоже, постоянно рыскают по всему интернету, в поисках новой информации, и заносят всю важную информацию в свои базы. Если сайт проиндексирован, то он будет доступен в поиске.

Зачем нужно запрещать индексацию сайтов.

Есть несколько причин. Но главная, а по сути, единственно важная, это необходимость закрыть индексацию для новых сайтов, или же, для сайтов, которые проводят глобальную реорганизацию.

На молодых сайтах, еще слишком мало информации, и попадание в индекс поисковых систем, не принесет особых плюсов. Зато минусы принести может. На сайте могут быть множество ошибок, а значит, сайт получит пессимизацию. Или просто мало контента. Что в свою очередь, также не будет способствовать любви поисковых систем.

То же самое, касается и сайтов при реорганизации. В этот момент, на сайте идут масштабные работы, и поисковикам сами эти работы, лучше не видеть. Лучше впустить их затем на готовый сайт.

Бывает, что запрет индексации ставят и для того, чтобы чужие не зашли на сайт, и не смогли прочитать то, что на этом сайте. Но в этом случае, запрет индексации сайта, это не панацея, поскольку, с одной стороны, не дает сто процентной гарантии, с другой стороны, на сайт могут зайти и по ссылкам с других сайтов. О том, как сделать закрытые разделы на сайте, я поговорю в другой раз.

Способы закрытия сайта от индексации.

Есть четыре основных способа запрета сайта от индексации.

- Запрет индексации при помощи файла robots.txt

- Закрытие средствами WordPress (для сайтов на wordpress).

- Запрет с использованием мета тегов.

- Запрет индексации сайта при помощи файла .htaccess

В самом начале, вам нужно сделать другой обязательный шаг – добавить ваш сайт в Гугл вебмастерс, и в Яндекс вебмастерс.

Как закрыть сайт от индексации в robots.txt

Robots.txt, это текстовый файл, находящийся в корневой папке сайта. В нем прописывается, что запрещено делать поисковым роботам. И в нем же, можно указать запрет на индексацию всего сайта.

Если у вас еще нет этого файла, то вы можете создать его сами. Для этого, нужно просто создать обычный, текстовый файл, например, в программе блокнот. Только не нужно создавать файл в программе Word, или ему подобных, тяжелых офисных программах.

Также имейте в виду, что название файла должно быть robots.txt, и ничего другого. То есть, обязательна буква s на конце, обязательно маленькие буквы. Иначе, поисковые роботы, его проигнорируют. Я как то уже писать про составление robots.txt для wordpress.

Закрытие сайта от индексации в Яндекс.

После этого, нужно закрыть сайт от индексации в Яндекс. Для этого, можно воспользоваться директивой «Disallow», после чего, сохраните файл в корневой папке вашего сайта.

Теперь, для поискового робота Яндекс, будет стоять запрет. Чтобы проверить, сработал ли запрет, нужно зайти в Яндекс Вебмастер, и проверить любую из страниц сайта инструментом «анализ robots.txt».

Закрытие сайта от индексации в Google.

Аналогично запрету в Яндекс, точно также можно сделать запрет на индексацию в Гугл. Только в этом случае, нужно закрыть Гугл робота.

Ну и точно также, можно закрыть вообще от всех роботов, для этого, можно просто прописать две строчки.

User-agent: *Disallow: /

Запрет индексации сайта при помощи файла robots.txt, простой метод. Но у него есть один недостаток, он не ненадежен. Особенно это касается Гугл. Для него, да и для Яндекса тоже, директивы, прописанные в файле robots.txt, скорее носят рекомендательный характер, но в случае, если роботы поисковиков посчитают нужным проиндексировать сайт, то они это сделают.

Закрытие сайта от индексации в WordPress

Популярная CMS WordPress, имеет свое решение. Таким образом, вебмастер может запретить индексацию, прямо из панели управления сайтом. Перейти в «Настройки» — «Чтение».

Но, как и в случае с файлом robots.txt, запрет к индексации сайта через панель WordPress, не дает сто процентной гарантии.

Запрет с использованием мета тегов.

Для запрета индексации сайта, можно применить специальный html тег:

meta name="robots" content="noindex,nofollow"

Разместив этот тег на странице сайта, вы сообщаете поисковикам (этот тег понимают и Яндекс и Гугл), что эту страницу индексировать не надо. А также, ненужно индексировать ссылки на этой странице.

В отличии от использования файла robots.txt, тег robots, является обязательным для исполнения. Но минус этого метода в том, что проставлять придется его на каждой из страниц сайта. Именно этот тег используют различные SEO плагины в WordPress, но с небольшой разницей.

meta name="robots" content="noindex,follow"

Здесь вы говорите поисковикам, что страницу индексировать не нужно, но ссылки индексировать нужно.

Если у вас WordPress, то вы просто можете поставить другой плагин, который будет проставлять именно первый тег, то есть, будет ставить запрет и на индексацию страницы в целом, и запрет на индексацию ссылок, расположенных на этой странице. Для этого можно воспользоваться плагином – Robots Meta. Его вы сможете найти на странице поиска плагинов.

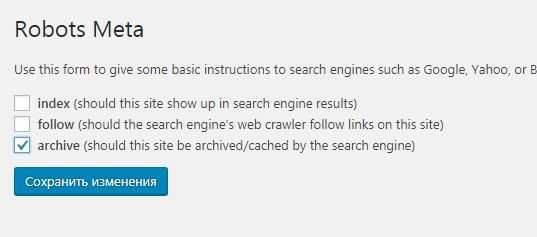

Robots Meta имеет простейшие настройки. Для того, чтобы изменить настройки, нужно зайти в пункт «Настройки», и выбрать «Robots Meta»

После чего, снять галочки с первых двух пунктов

Теперь во все страницы сайта, будет включен мета тег, запрещающий индексацию.

Закрыть весь сайт от индексации в файле .htaccess

Ну и последний пункт, это использование файла .htaccess. Это один из файлов настройки, который находится в корневой папке хостинга, то есть, там же, где находится и файл robots.txt. Однако, на некоторых хостингах, этот файл может быть недоступным (обычно на бесплатных хостингах, он недоступен).

Для того, чтобы закрыть файл, достаточно прописать в этом файле всего одну строчку:

deny from all

Но не торопитесь этого делать. Дело в том, что данная команда, закрывает вообще весь сайт, и не только от поисковых роботов, но и от людей тоже. И если ваш сайт использует доступ через админскую панель, то и она (админская панель), будет закрыта. Доступ к сайту будет только через FTP.

Но кроме полного закрытия сайта, можно просто поставить пароль на сайт. И это абсолютный метод, благодаря которому, вы сможете закрыть свой сайт от поисковых систем. Ну а как поставить пароль на сайт через файл .htaccess, смотрите в видео.

life-crazy.ru

это не повод для паники

Время чтения: 10 минут

Нет времени читать?

Отправим материал вам на:Из этой статьи вы узнаете:

- Что значит «сайт закрыт от индексации»

- Что именно на сайте необходимо закрывать от индексации

- Как закрыть сайт от индексации полностью

- Как закрыть от индексации отдельно папки, файлы, картинки

- Как проверить закрыт ли сайт от индексации

Согласитесь, сегодняшняя тема довольна необычна. Если вы – начинающий интернет-предприниматель, то больше всего вас интересует трафик на ваш сайт и появление его страниц в поисковиках. Почему же иногда сайты специально закрывают от индексации? Попробуем объяснить, что значит – сайт закрыт от индексации.

Сайт закрыт от индексации – что это значит

Поисковая индексация сайта – это процесс занесения страниц в базу данных поисковых систем. То есть именно благодаря индексации поисковая система узнает о вашем ресурсе, его содержимом и о том, насколько сайт ценен для пользователей.

На страницы сайта заходит поисковой робот (виртуальная программа) и считывает размещенную на них информацию. После этого она подлежит занесению в базы данных поисковиков и ранжированию.

Есть два способа, с помощью которых поисковой робот узнает о новом веб-ресурсе: через ссылку, размещенную на одном из известных сайтов, либо в случае самостоятельного добавления веб-мастером своего сайта в индексацию.

Рекомендуемые статьи по данной теме:

Посещения робота являются периодическими, в связи с этим актуальность индексации сайта всегда высокая. То есть о внесении изменений на страницы вашего сайта или добавлении новых страниц робот быстро узнает, и информация будет учтена.

Для обеспечения успешного прохождения поисковой индексации и ее высокого качества необходимо соблюдение следующих требований:

- Следует обеспечить постоянный доступ к сайту. Если робот, проводящий индексацию, зайдет на сайт, доступ к которому закрыт, то страница в поиск не попадет. Неоднократное повторение таких ситуаций приведет к снижению траста сайта.

- Необходимо обеспечить быструю загрузку страниц сайта. Ситуация с медленной загрузкой страниц аналогична ситуации, в которой к ним нет доступа.

- Качество контента, публикуемого на сайте, должно быть высоким. Если вы не позаботитесь о качестве содержимого страниц, то после индексации могут быть наложены фильтры, в результате чего они будут исключены из поиска.

- Чем чаще будут выкладываться новые материалы, тем более частыми будут посещения поискового робота, а индексация страниц – более быстрой. Соответственно, в случае редких публикаций индексация будет более медленной.

По какой причине может быть сайт закрыт от индексации?

Например, вы только приступаете к разработке сайта, внося изменения в него напрямую. На этом этапе ресурс и его содержимое не такие, какими их предполагается преподнести в итоге пользователям. Поэтому разумно закрыть страницы сайта от индексации в Google и Яндекс до окончания работ над ним.

Что именно на сайте необходимо закрывать от индексации

Сайт будет проиндексирован, а страницы ранжированы хорошо, если поисковая система обойдет ключевые страницы сайта, нуждающиеся в продвижении, и при этом сумеет точно определить, какой контент является основным.

Сайты, которые нам приходится анализировать, имеют ошибки двух типов:

- Продвигая свой ресурс, владельцы не вникают, какие данные видит и добавляет в индекс поисковый робот. Это приводит к заполнению индекса ненужными страницами (а не продвигаемыми) и их перегрузке.

- Противоположная ситуация: излишняя чистка сайта. Помимо ненужных данных, могут оказаться недоступными и те, которые важны для продвижения и оценки страниц.

Рассмотрим, что на самом деле не должны видеть поисковые роботы, и как лучше прятать информацию:

Контент

Оценка страниц поисковыми роботами является комплексной и для нее используются не только текстовые показатели. Закрывая различные блоки, можно спрятать сведения, которые, наоборот, помогают оценивать и ранжировать страницы.

Какие ошибки наиболее распространены:

- Прячут шапку сайта. Как правило, в ней указываются контакты, ссылки. Закрытие шапки повышает вероятность того, что поисковая система не узнает о наличии на вашем сайте размещенной на видном месте важной информации.

- Закрывают от индексации фильтры, форму поиска, сортировку. Если интернет-магазин имеет такие возможности, то лучше их не скрывать, ведь это важный коммерческий показатель.

- Закрывают доступ к данным об оплате и доставке. Это один из способов повышения уникальности на карточках товара. Тем не менее, без этой информации карточка не может быть качественной.

- Убирают со страниц меню. Как следствие, навигация по сайту может быть оценена как неудобная.

С какой целью часть содержимого сайта закрывают?

- Хотят акцентировать внимание именно на основном контенте странице, для чего убирают из индекса вспомогательные данные, служебные блоки, меню.

- Стремятся повысить уникальность страницы, ее полезность, для чего закрывают блоки-дублеры.

- Хотят убрать «лишний» контент, добиться более высокой текстовой релевантности страницы.

Однако эти цели вполне достижимы и без закрытия части контента!

- Ваше меню очень большое?

Выходом будет выведение на страницах лишь непосредственно относящихся к разделу пунктов.

- В фильтрах много возможностей выбора?

Тогда в основном коде нужно выводить только популярные, а остальные загружать только по требованию посетителя нажатием кнопки «показать все». Да, предполагается использование скриптов, но ведь вы не обманываете пользователя. Поисковый робот сможет увидеть все пункты, однако значение их будет оценено не так, как основных.

- Новостной блок имеет слишком большие размеры?

Выкладывайте меньше новостей, либо публикуйте только заголовки, либо вовсе избавьтесь от этого блока, если пользователи им не интересуются или на странице мало основного контента.

Поисковики не идеальны, однако становятся все более совершенными. В настоящее время Google, если обнаруживает скрытые от индексации скрипты, выдает ошибку в панели Google Search Console (вкладка «Заблокированные ресурсы»).

Оставить заявку

Закрывать доступ роботам к части содержимого сайта иногда полезно, но это не позволит оптимизировать сайт. Использовать такой способ можно лишь в случае крайней необходимости.

Что можно посоветовать:

- Рассматривайте скрытие информации в качестве «костыля», и прибегайте к нему в крайних случаях. Лучше доработать саму страницу.

- Когда удаляете что-либо со страницы, ориентируйтесь не только на текстовые показатели. Не забывайте об оценке удобства и информации, оказывающей влияние на коммерческие факторы ранжирования.

- Перед скрытием контента поэкспериментируйте на нескольких тестовых страницах. Поисковые боты способны разбирать страницы, поэтому может оказаться, что вы напрасно боитесь снижения релевантности.

Рассмотрим используемые для скрытия содержимого сайтов методы:

Noindex

Имеет ряд недостатков. Во-первых, с помощью этого тега можно скрыть контент только от Яндекса, а закрыть доступ к тексту Google невозможно.

Кроме того, возможен запрет на индексацию и включение в выдачу поисковика только текстовых данных. Применительно к другим данным (например, ссылкам) он не действует. Это видно из описания тега в справке Яндекса.

Техподдержка Яндекса не раскрывает, как работает noindex. Немного больше можно об этом узнать из обсуждения в официальном блоге.

Когда целесообразно использовать тег:

- если вы подозреваете, что позиция страницы в Яндексе занижена вследствие переоптимизации, хотя в поисковой выдаче Google по ключевым фразам находится вверху. Но знайте, это быстрое и временное решение. В случае попадания под «Баден-Баден» всего сайта noindex проблему не решит. Об этом говорят и представителя Яндекса;

- в целях скрытия общей служебной информации, не указать которую на странице вы не можете, не нарушив корпоративных или юридических нормативов;

- чтобы откорректировать сниппеты в Яндексе в случае попадания в них нежелательного контента.

AJAX

Метод отличается универсальностью. Применяется для скрытия информации и от Яндекса, и от Google. Это лучший способ чистки сайта от размывающего релевантность контента. Поисковые системы такой метод не одобряют. Для них желательно, чтобы поисковые роботы имели доступ к тому же контенту, что и посетители.

Очень многие используют технологию AJAX. Если не заниматься откровенным клоакингом, то санкций за это можно избежать. Минусом метода является необходимость закрытия доступа к скриптам, хотя поисковики не рекомендуют этого делать.

Страницы сайта

Чтобы успешно продвигать сайт, следует не только почистить страницы от лишнего контента, но и исключить из поискового индекса сайта «мусор» - страницы, не несущие пользы. Благодаря этому продвигаемые страницы будут индексироваться более быстро. Кроме того, если в индексе будет много мусорных страниц, то это плохо скажется на оценке ресурса и его продвижении.

Какие страницы следует прятать:

- страницы оформления заказов, корзины пользователей;

- результаты поиска по сайту;

- личные данные пользователей;

- страницы результатов сравнения товаров и других модулей вспомогательного характера;

- страницы, генерируемые фильтрами поиска и сортировкой;

- страницы административной части сайта;

- версии для печати.

Какие есть способы закрытия страниц от индексации:

Rtxt

Метод не очень хорош. Во-первых, файл robots не может бороться с дублями и чистить сайты от мусорных страниц. Во-вторых, robots закрыть сайт от индексации позволяет не всегда.

Noindex

Использование этого метатега делает возможным гарантированное исключение страниц из индекса.

Синтаксис у Яндекса и Google различен.

Вот метатег, который понимают оба поисковика:

<meta name="robots" content="noindex, nofollow">

Googlebot будет видеть метатег noindex, если доступ к страницам, закрытым в файле robots.txt, будет закрыт. В противном случае бот, возможно, даже не посетит эти страницы.

Защита с помощью пароля

Этот способ следует применять для скрытия конфиденциальных данных. Google выделяет его как отличающийся надежностью.

Если надо закрыть доступ ко всему сайту (к примеру, к тестовой версии), то этот метод подойдет как нельзя лучше. Но и он несовершенен – вы можете столкнуться с трудностями, если понадобится просканировать запароленный домен.

AJAX

Это метод не просто для исключения из индекса страниц, которые генерируются фильтрами, сортировкой и т.д., а для исключения возможности их создания.

К примеру, если посетитель выбрал в фильтре нужные параметры, под которые нет отдельной страницы, то при изменении отображаемых на странице товаров непосредственно URL изменяться не будет.

Этот способ непростой, поскольку невозможно его применение одновременно для всех случаев. Часть формируемых страниц используется для продвижения.

К примеру, страницы, генерируемые фильтрами. Для «холодильник + Samsung + белый» страница необходима, а для «холодильник + Samsung + белый + двухкамерный + no frost» – уже нет. В связи с этим нужен инструмент для создания исключений. Это делает работу программистов более сложной.

Топ-5 статей, которые будут полезны каждому руководителю:

Методы запрета индексации от поисковых алгоритмов

- «Параметры URL» в Google Search Console.

С помощью этого инструмента можно установить способ идентификации появления в URL страниц новых параметров.

- Директива Clean-param вtxt.

Для прописывания аналогичного запрета для параметров URL в Яндексе используется директива Clean-param.

Инструменты точечного удаления страниц

При необходимости срочного удаления данных из индекса и невозможности ждать, пока запрет увидят поисковые роботы, применяют инструменты из панели Яндекс Вебмастер и Google Search Console.

В Яндексе это «Удалить URL»:

В Google Search Console - «Удалить URL-адрес»:

Внутренние ссылки

Запрет на индексирование внутренних ссылок делают с целью перераспределить внутренний вес на ключевые продвигаемые страницы. Однако нужно помнить:

- такое перераспределение негативно сказывается на общих связях между страницами;

- ссылки из шаблонных сквозных блоков, как правило, меньше весят или вовсе не подвергаются учету.

Какими способами можно скрывать ссылки:

Noindex

Этот тег можно использовать только для запрета доступа к текстовому контенту. Ссылки с помощью него не скрыть.

Атрибут rel=”nofollow”

В настоящее время с его помощью невозможно сохранение веса на странице. Использование rel=”nofollow” ведет к потере веса, поэтому использовать этот тег для внутренних ссылок нелогично. Googlе не рекомендует обращаться к этому инструменту.

Скрипты

Этот метод действительно позволяет прятать ссылки от поисковиков. Возможно использование Аjax и подгрузки блоков ссылок уже после загрузки страницы либо добавление ссылок с подменой тега <span> на <a> скриптом, однако помните, что поисковым алгоритмам под силу распознавание скриптов.

Аналогично ситуации с контентом – это «костыль», прибегать к помощи которого стоит не всегда. Если нет уверенности в целесообразности скрытия блока ссылок, то откажитесь от использования подобных методов.

Как полностью закрыть сайт на Wordpress от индексации

Способ 1. Через встроенную функцию в WordPress

Удаление ресурса из поисковиков – процесс несложный. Осуществляется он с помощью встроенной функции в WordPress «закрыть сайт от индексации» и сканирования. Для этого:

- На панели управления администратора зайдите в Настройки, выберите Чтение.

- Найдите опцию «Видимость для поисковых систем». Поставьте галочку напротив «Попросить поисковые системы не индексировать сайт». Когда опция включится, файл txt подвергнется редактированию в соответствии с новыми правилами.

- Нажмите «Сохранить изменения», чтобы они вступили в силу.

Способ 2. Закрыть сайт от индексации через robots.txt

Если вам больше по душе делать все вручную, то можно самим заняться редактированием данного файла. Результат будет аналогичен. С помощью файла Роботс закрыть сайт от индексации нетрудно:

- Для доступа к файлам вашего сайта используйте Файловый менеджер или FTP-клиент.

- Найдите файл txt. Его местонахождение – папка, где расположен и WordPress (как правило, public_html). Если найти файл не получается, можно создать пустой.

- Закрыть сайт от индексации поисковиков можно, введя следующий синтаксис:

User-agent: *

Disallow: /

Первый код позволяет предотвратить как сканирование, так и индексацию вашего ресурса. Этот код в файле robots.txt – сигнал для поисковиков о том, что сканировать сайт запрещено.

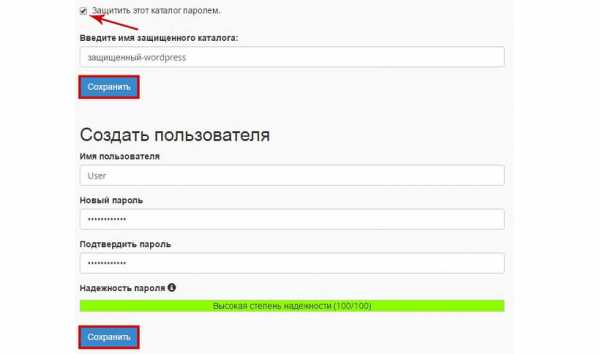

Способ 3. Защита сайта паролем с помощью контрольной панели вашего хостинга

Поисковикам и поисковым роботам доступ к файлам, которые защищены паролем, закрыт. Существуют следующие способы защиты файлов паролем:

Если вы – клиент Hostinger, то для включения функции защиты паролем вам нужно использовать инструмент, который называется «Защита Папок Паролем».

- Войдите в контрольную панель Hostinger и нажмите иконку Защита Папок Паролем.

- Слева отобразятся каталоги. Укажите те, которые нуждаются в защите. В нашем случае WordPress установлен в

- Выбрав каталог, введите имя пользователя и пароль в панели справа, нажмите «Защитить».

Процесс будет аналогичным и в случае использования cPanel. Потребуется:

- Войти в учетную запись cPanel и нажать Конфиденциальность каталога.

- Выбрать папку установки WordPress. Как правило, это

- Выбрать опцию «Защитить этот каталог паролем». После нужно ввести имя каталога и нажать «Сохранить». С помощью формы создать учетную запись пользователя для доступа к защищенным каталогам. После нажать «Сохранить».

Способ 4. Запаролить сайт, используя плагин

Получить аналогичный результат можно, установив плагины. Есть много плагинов, которые можно использовать в таких целях. Стоит выделить следующие: Password Protected Plugin, WordFence. Ваша задача – выбрать наиболее свежий и установить его.

После установки нужно будет зайти в настройки плагина и установить пароль для сайта. После того как вы защитите ваш ресурс паролем, доступ поисковикам к нему закроется. Соответственно, индексация ими сайта станет невозможной.

Как закрыть сайт от индексации на Opencart

Защитить от индексации поисковых систем сайт на Opencart невозможно, просто выключив в админке самого интернет-магазина! Посещение вашего закрытого сайте поисковыми роботами продолжится. Они будут тащить его в индекс, что негативно скажется на продвижении.

Хороший выход – закрыть доступ к сайту, отредактировав файл robots.txt. Понадобится удалить все, оставив только пару строк из всего содержимого этого файла.

Как запретить индексирование поисковыми роботами веб-ресурса:

User-agent: * Disallow: /

Как в Битрикс закрыть сайт от индексации

Для этого нужно использовать метатег <meta name="robots" content="noindex, nofollow">. Для скрытия какой-либо страницы от индексирования нужно, добавляя или изменяя условия, выбрать пункт «Закрыть от индексации».

Кроме того, возможно отключение индексации всех страниц с подключенным компонентом sotbit:seo.meta. Для этого нужно зайти в общие настройки модуля SEO умного фильтра и включить опцию «Отключить индексацию всех страниц».

Приоритетными будут настройки индексации в условии, а не эта опция. То есть в случае отключения в настройках условия опции «Закрыть от индексации» страница, удовлетворяющая этому условию, будет проиндексирована.

Как закрыть на сайте от индексации папки, файлы, картинки и поддомен

Закрыть от индексации отдельную папку

Если папка отдельная, то можно закрыть к ней доступ поисковикам опять же в файле robots.txt, явно указав ее (закроется доступ ко всему содержимому этой папки).

User-agent: * Disallow: /folder/

Если папка закрыта, а какой-либо файл из нее вы желаете проиндексировать, то вам нужно применить одновременно оба правило Allow и Disallow:

User-agent: * Аllow: /folder/file.php Disallow: /folder/

Закрыть от индексации файл

Процесс аналогичный.

User-agent: Yandex Disallow: /folder/file.php

При необходимости закрытия файла в Google в анкете нужно указать, как он называется.

Закрыть от индексации картинки

Чтобы закрыть доступ к изображениям форматов jpg, png и gif, используйте следующие команды:

User-Agent: * Disallow: *.jpg Disallow: *.png Disallow: *.gif

Закрыть от индексации поддомен

В основном, каждый поддомен веб-ресурса имеет свой файл robots.txt. Как правило, его местонахождением является папка, корневая для поддомена. Необходима корректировка содержимого файла: нужно указать разделы, которые хотите закрыть, используя для этого директорию Disallow. Если файла нет, нужно создать его.

2 варианта, как проверить закрыт сайт от индексации или нет

Вариант №1. С помощью расширения

Если вы пользуетесь браузером Сhrome, то установите расширение NoFollow Simple. Если же вы используете другой браузер, то понадобится установка именно Сhrome.

После установки нужно открыть его и кликнуть на значок в верхнем правом углу левой клавишей мышки. В раскрывшемся списке инструментов выбрать Расширения.

Снизу этой страницы ищем Еще расширения, кликаем на них. Открывается страница интернет-магазина Сhrome. Не пугайтесь, там есть и бесплатные вещи. Смело вбивайте в поиск «Сhrome расширение NoFollow Simple», скачивайте и включайте его.

В дальнейшем благодаря этому расширению, загружая любой сайт, вы будете видеть такое изображение:

В красной рамке будут ссылки, индексация которых поисковыми роботами не была проведена.

Как видите, ничего сложного!

Вариант №2. С помощью кода страницы

Если вы хотите избежать установок, а индексацию ссылки знать нужно, вам подойдет следующий вариант. Ссылку для определенной страницы любого сайта из любого браузера можно проверить с помощью кода страницы.

Переходите на эту страницу, кликнув правой клавишей мышки, выбирайте Просмотр кода страницы или Исходный код (это зависит от браузера).

Когда страница откроется, нужно нажать F3 и ввести в открывшееся окошко нужную ссылку. Как в примере ниже.

Она выделилась оранжевым цветом. Перед ней стоит параметр rel=”nofollow”. Это говорит о том, что ссылка недоступна для индексирования. Если вам нужна ссылка, прошедшая индексацию, этого параметра быть не должно.

Оставить заявку

sales-generator.ru

как закрыть от индексации отдельную страницу сайта

Привет вебмастера-начинающие и те, кто на этом деле собаку съел. Сегодня урок для вебмастеров уровня «начинающий». Хочу показать как полностью закрыть сайт от индексации для поисковых систем. Еще расскажу как закрыть от индексации любую отдельную страницу или запись на сайте. Т.е. сделаем так, чтобы наш сайт поисковики не индексировали и наш сайт не показывался в выдачи (ну или одна конкретная страница). Да-да, иногда нужно не только «бороться» за ТОП (в чем вам поможет онлайн-сервис SeoPult), но бывают ситуации, когда нужно «спрятаться».

Привет вебмастера-начинающие и те, кто на этом деле собаку съел. Сегодня урок для вебмастеров уровня «начинающий». Хочу показать как полностью закрыть сайт от индексации для поисковых систем. Еще расскажу как закрыть от индексации любую отдельную страницу или запись на сайте. Т.е. сделаем так, чтобы наш сайт поисковики не индексировали и наш сайт не показывался в выдачи (ну или одна конкретная страница). Да-да, иногда нужно не только «бороться» за ТОП (в чем вам поможет онлайн-сервис SeoPult), но бывают ситуации, когда нужно «спрятаться».

Зачем закрывать сайт от индексации? — например, вы купили домен, создали сайт, но у вас нету времени им заниматься, вы просто закрываете его для индексации, и ПС обходят его стороной. Когда настроите сайт, опубликуете несколько статей, тогда открываете его для индексации, добавляете в поисковые системы Яндекса и Гугла — сайт начинает индексироваться.

[sc:adsense850 ]

Или у вас есть сайт для различных экспериментов (тестирования разных плагинов, шаблонов, скриптов и т.д.), который также не должен появиться в выдачи. (К примеру, дубль моего блога сделан на поддомене, где я с ним провожу различные опыты. Где я изучаю различные свойства CSS и по другому издеваюсь над ним)

Или вы делаете свой первый сайт не на Денвере, а сразу на хостинге (что, кстати, всем и советую). Закрыли сайт, и колдуйте над ним сколько влезет

Зачем закрывать отдельные страницы? — вариантов может быть масса: не уникальный контент, куча исходящих ссылок, какие нибудь скрипты, рекламные коды… и тому подобное…

В общем, смысл ясен, для чего нужно закрыть сайт от ПС.

Как полностью закрыть сайт от индексации

Закрыть сайт можно двумя способами.

1 способ: Закрываем сайт от индексации в robots.txt

В файле robots.txt прописывает этот код:

User-agent: * Disallow: /Все, только эти две строчки. Сохраняем файл, загружаем в корневую папку сайта. Кто не знает что такое файл robots.txt, читаем статью: файл robots.txt для WordPress

2 способ: закрываем в админке WordPress

В админке WordPress → в меню → в параметрах → пункт «чтение» → «видимость для поисковых систем» поставить галочку «попросить поисковые системы не индексировать сайт» Сохранить изменения:

Если мне нужно закрыть сайт, то я делаю это и в админке WordPress, и в файле robots.txt

Как закрыть страницу (запись) сайта от индексации

Если вам нужно закрыть только какую-то одну страницу с сайта, например: my-site/stranica.html, то такое правило:

User-agent: * Disallow: /stranica.htmlДля закрытия страниц и записей можно воспользоваться плагином Robots Meta. Плагин качается из админки блога, после установки и активации никаких настроек не требует. В текстовом редакторе WordPress появляется виджет, в котором можете выбрать пункт запретить страницу или запись к индексации.

Если вас интересует разработка и создание сайтов с интуитивно понятным интерфейсом и уникальным дизайном, плюс продвижение сайта в поисковых системах, то советую обратить внимание на веб студию «Юка».

На сегодня все.

Удачи!

aimblog.ru